从GPT-1到GPT-4,再到未来的GPT-5,一文带你了解GPT的前世今生和未来!

引言

ChatGPT爆火的余热还没退去,GPT-4又横空出世,各大媒体都争相报道,朋友圈也在不断刷屏,打工人更是感叹饭碗要被AI夺走了!作为一名理性吃瓜群众我们还是得去了解一下GPT的过去、现在和未来,正所谓知己知彼,百战不殆,只有充分了解"对手",我们才能驾驭AI为我所用!话不多说,立马开始!

GPT-1之前:传统NLP遭遇瓶颈

首先我们要了解的是GPT(Generative pre-trained transformer 基于转换器的生成式预训练模型)是一个人工智能领域的NLP(Natural Language Processing 自然语言处理)模型,简单来说就是让计算机理解人类语言的模型。

NLP早在上世纪五六十年代就已经提出来了,而GPT-1是直到2018年才诞生的,那么这几十年间传统NLP是如何发展并取得成就的呢? 我们简单了解一下:

● 早期自然语言处理:第一阶段(60~80年代):基于规则来建立词汇、句法语义分析、问答、聊天和机器翻译系统。好处是规则可以利用人类的知识,不依赖太多外部数据,可以快速起步;问题是覆盖面不足,像个玩具系统,规则管理和可扩展一直没有解决。

● 统计自然语言处理:第二阶段(90年代开始):基于统计的机器学习(ML)开始流行,很多NLP开始用基于统计的方法来做。主要思路是利用带标注的数据,基于人工定义的特征建立机器学习系统,并利用数据经过学习确定机器学习系统的参数。运行时利用这些学习得到的参数,对输入数据进行解码,得到输出。机器翻译、搜索引擎都是利用统计方法获得了成功。

● 神经网络自然语言处理:第三阶段(2008年之后):深度学习开始在语音和图像发挥威力。随之,NLP研究者开始把目光转向深度学习。先是把深度学习用于特征计算或者建立一个新的特征,然后在原有的统计学习框架下体验效果。比如,搜索引擎加入了深度学习的检索词和文档的相似度计算,以提升搜索的相关度。自2014年以来,人们尝试直接通过深度学习建模,进行端对端的训练。目前已在机器翻译、问答、阅读理解等领域取得了进展,出现了深度学习的热潮。

总而言之,NLP从从基于规则模型的玩具系统到基于统计模型的崭露头角,再到基于深度学习的意外收获,在各种各样的任务中获得成功,但是也存在一些问题:

1. 这些任务都需要大量的标注数据进行训练才有不错的模型效果,但针对特定任务的高质量标注数据难以获取,通常都需要花费大量的人力物力才能得到数量不多的有效数据;

2. 而且某一个任务训练的模型很难泛化到其它任务中;

3. 更重要的是在目前的互联网上有海量的文本,只是这些文本是没有针对特定任务做标注的,被称为无标注文本,很难将这些文本应用到特定任务的训练,这未免有些遗憾和浪费

直到GPT-1诞生,这一切将不再是问题!

GPT-1:开启预训练大模型时代

2018年6月11日,OpenAI发表了一篇名为《通过生成式预训练提高语言理解能力》(Improving Language Understanding by Generative Pre-Training)的论文,在其中介绍了“基于转换器的生成式预训练模型”(Generative pre-trained transformer,GPT,后续又逐渐发表了更多模型,为了区分,这里称之为GPT-1)。当时,表现最好的自然语言生成模型主要依靠大量手动标注数据的监督学习。这种依赖于人类监督学习的开发途径限制了模型在未经精细标注的数据集上的应用;许多语言(例如斯瓦希里语或海地克里奥尔语)也因缺乏能建立起语料库的文本资料而造成实际应用(如翻译和解释)上的困难;此外,训练超大模型相当耗时且开支非常昂贵。

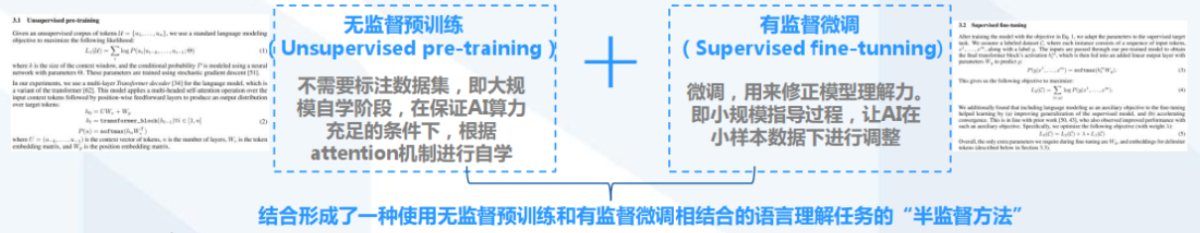

相比之下,GPT-1提出了一种“半监督(semi-supervised)”(后来普遍称为“自监督”)的方法——先在没有标号的数据上面训练一个预训练模型,再在少量标号数据上面训练一个分辨的微调模型。

GPT-1的训练数据为BookCorpus:是一个包含7000本未出版书籍的语料库(这些书籍因为没有发布,所以很难在下游数据集上见到,更能验证模型的泛化能力),总大小为4.5 GB,这些书籍涵盖了各种不同的文学流派和主题。参数数量为1.2亿 ! 至此,科学家们开始相信大力出奇迹,大模型时代拉开帷幕 !

附:

GPT-2:无监督预训练模型做有监督任务

2019年2月OpenAI 在GPT-1的基础上又发布了GPT-2,进行了诸多改进,实现执行任务多样性,开始学习在不需要明确监督的情况下执行数量惊人的任务。在GPT-2阶段, OpenAI去掉了GPT-1阶段的有监督微调( fine-tuning),成为无监督模型。在其相关论文中它在8个测试语言建模数据集中的7个数据集上实现了当时最先进的结果。

GPT-2的参数数量和训练数据集的大小均增加了十倍,具有15亿参数,数据集为WebText:一个包含八百万个文档的语料库,总大小为40 GB。这些文本是从Reddit上投票最高的4,500万个网页中收集的,包括各种主题和来源,例如新闻、论坛、博客、维基百科和社交媒体等。

GPT-2聚焦在无监督、 zero-shot(零次学习)上,然而GPT-2训练结果也有不达预期之处,所存在的问题也亟待优化。在GPT-2阶段,尽管体系结构是任务无关的,但仍然需要任务特定的数据集和任务特定的微调:要在所需任务上实现强大的性能,通常需要对特定于该任务的数千到数十万个示例的数据集进行微调。很多实验也表明随着模型容量和数据量的增大,GPT-2的潜能还有进一步开发的空间,基于这个情况,诞生了我们后面要介绍的GPT-3。

附:

GPT-3:AI革命的突破性进展

OpenAI于2020年5月发表GPT-3的论文,参数相对于GPT-2增加了两个数量级以上,1750亿参数,570 GB的大规模文本语料库,其中包含约四千亿个标记。这些数据主要来自于CommonCrawl、WebText、英文维基百科和两个书籍语料库(Books1和Books2)

改进的算法、强大算力和数据的增加推动了AI的革命,让GPT-3成为当时最先进的语言模型。GPT-3在许多NLP数据集上都有很强的性能(包括翻译、问题解答和完形填空任务),以及一些需要动态推理或领域适应的任务(如解译单词、在句子中使用一个新单词或执行算术)。 GPT-3甚至可以生成新闻文章样本(已很难将其与人类撰写的文章区分开来),GPT-3原始论文的作者们警告了GPT-3有可能对于社会的负面影响,比如利用制造假新闻的可能性。英国《卫报》即使用GPT-3生成了一个关于人工智能对人类无威胁的评论专栏。李开复称卷积神经网络与GPT-3为人工智能重要的改善,两者皆是模型加海量数据的成果。斯坦福大学的研究发现,GPT3已经可以解决70%的心智理论任务,相当于7岁儿童。

附:

● InstructGPT:赋予GPT理解人类指令能力

2022年2月,OpenAI在GPT-3基础上进一步强化推出 InstructGPT模型,使用来自人类反馈的强化学习方案RLHF( reinforcement learning from human feedback),训练出奖励模型( reward model)去训练学习模型( 即:用AI训练AI的思路)

训练步骤为: 对GPT-3监督微调->训练奖励模型( reward model)->增强学习优化SFT (第二、第三步可以迭代循环多次)

InstructGPT通过对大语言模型进行微调,从而能够在参数减少的情况下,实现优于GPT-3的功能。

● GPT-3.5:赋予GPT代码能力和思维链能力

2022 年 3 月 15 日,OpenAI 在其 API 中提供了新版本的 GPT-3 和 Codex(获取代码片段之间的统计相关性,解析自然语言并生成代码),具有编辑和插入功能。

与 GPT-3 相比,GPT-3.5 增加了代码训练与指示微调:

代码训练(Code-training):让 GPT-3.5 模型具备更好的代码生成与代码理解能力,同时间接拥有了复杂推理能力;

指示微调(Instruction-tuning):让 GPT-3.5 模型具备更好的泛化能力,同时模型的生成结果更加符合人类的预期。

● ChatGPT:赋予GPT对话能力并提升了理解人类思维的准确性

OpenAI于2022年11月推出其开发的人工智能聊天机器人程序ChatGPT,在此前基础上增加了Chat属性,且开放了公众测试。

ChatGPT目前以文字方式交互,但除了可以用人类自然对话方式来交互,还可以用于复杂的语言工作,包括自动生成文本、自动问答、自动摘要等多种任务。如:在自动文本生成方面,ChatGPT可以根据输入的文本自动生成类似的文本(剧本、歌曲、企划等),在自动问答方面,ChatGPT可以根据输入的问题自动生成答案。还有编写和调试计算机程序的能力。ChatGPT可写出相似真人的文章,并在许多知识领域给出详细和清晰的回答而迅速获得关注,证明了从前认为AI不会取代的知识型工作它也足以胜任,对人力市场的冲击相当大。

ChatGPT提升了理解人类思维的准确性的原因在于利用了基于人类反馈数据的系统进行模型训练

附:

论文:[2005.14165] Language Models are Few-Shot Learners

代码:GitHub - openai/gpt-3: GPT-3: Language Models are Few-Shot Learners

GPT-4:多模态模型、AI新里程碑

2023年3月14日OpenAI发布GPT-4轰动了整个科技界,据OpenAI自己称,GPT-4将是该公司里程碑式的模型。在其概念视频中,OpenAI介绍GPT-4可以解决更复杂的问题、编写更大型的代码,并通过图片产生文字。此外,OpenAI还承诺GPT-4相比之前的模型,包括ChatGPT此前应用的GPT-3.5,将更加安全且具协调性。

GPT-4的回答准确性不仅大幅提高,还具备更高水平的识图能力,且能够生成歌词、创意文本,实现风格变化。此外,GPT-4的文字输入限制也提升至2.5万字,且对于英语以外的语种支持有更多优化。

GPT-4 是 OpenAI 花了 6 个月的时间,利用对抗性测试程序和 ChatGPT 中积累的经验迭代调整,模型尽管远非完美,但该模型“比以往任何时候都更具创造性和协作性”,并且“可以更准确地解决难题”。

目前GPT-4虽然在许多现实世界场景中的能力不如人类,但在各种专业和学术基准上表现出人类水平。

总之一句话,GPT-4牛逼 !

当然关于AI是否会在某些工作上取代人类的讨论一直没停过,不过GPT-4诞生后打工人更加着急了,很多方面确实不如AI啊 !

● AI做题家

GPT-4在模拟律师资格考试中的成绩位于前10%的考生,而 GPT-3.5 的成绩在后10%,除了律师考试,GPT-4还在美国大学入学测试SAT中考到710分,虽然分数不高,但已经够上美国大学录取水平。更重要的是,GPT-4能在大学的基础微积分课程中获得4的成绩(5分为满分),这证明了该模型已经掌握了高等数学大部分的概念。

● 不会和产品经理打架的AI程序员

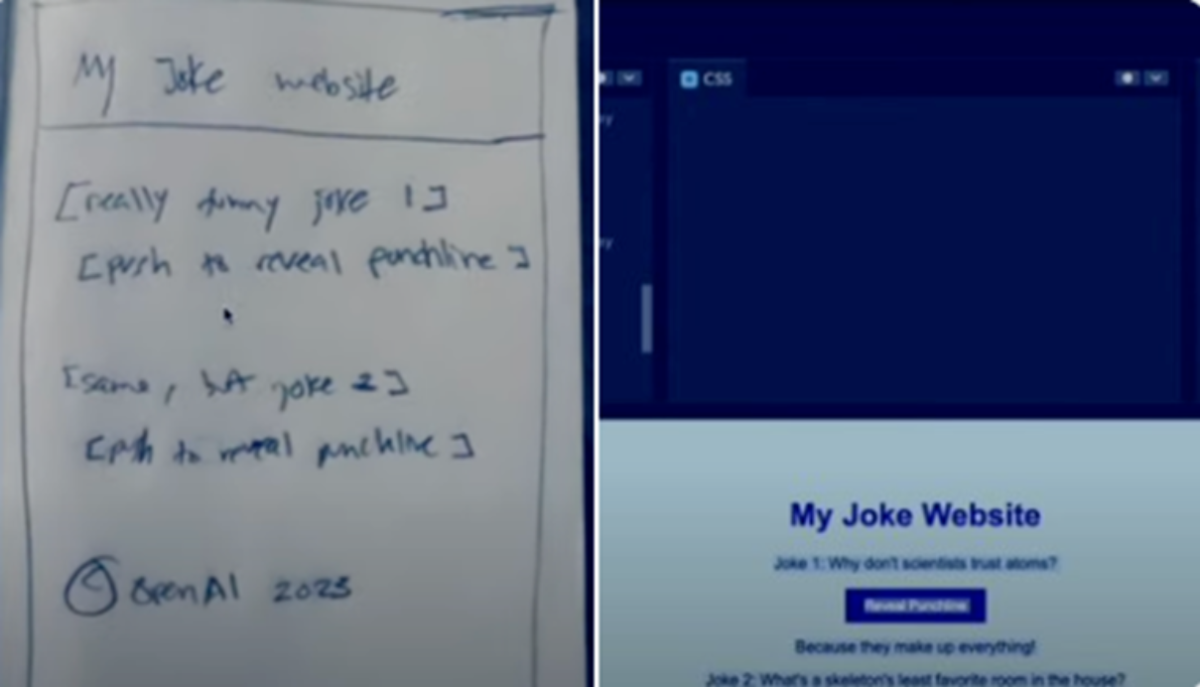

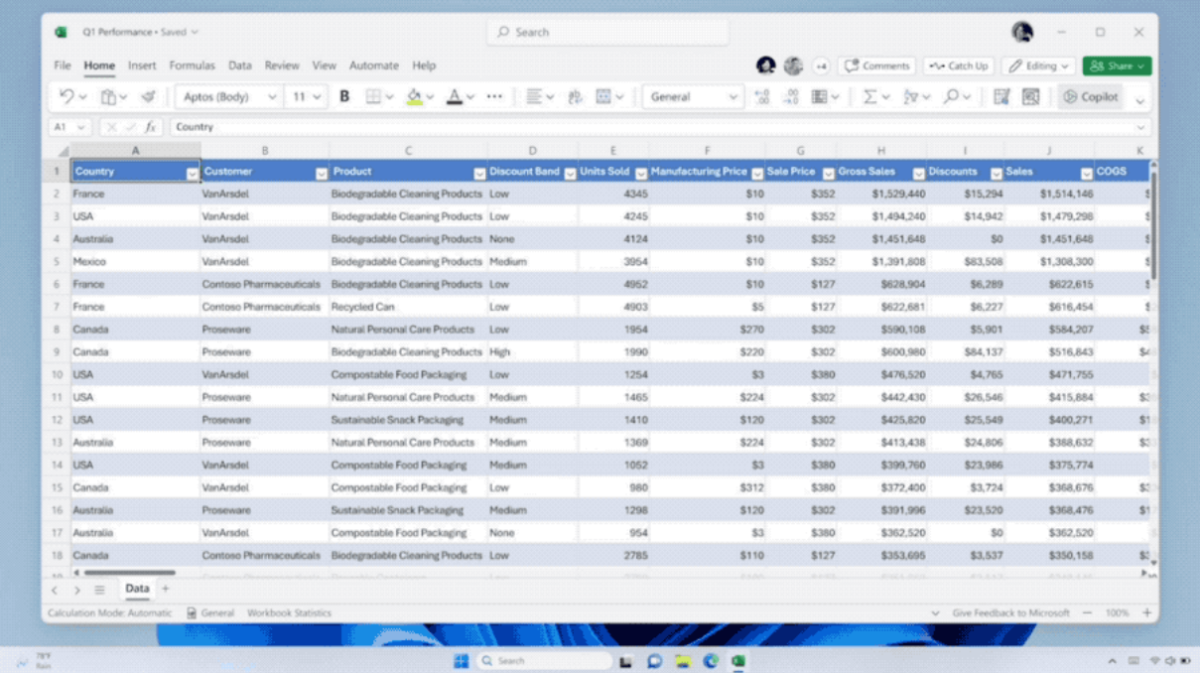

GPT-4 可以接受文本和图像的提示,这使用户可以指定任何视觉或语言任务。具体来说,它在输入中交错文本和图像,生成文本输出(自然语言、代码等)

GPT-4现在已经可以通过用户的简单需求直接生成代码,甚至网站。即便用户只是在餐巾纸上画了个简单界面,GPT-4都能直接搞出一个可运行的网站。

● 量子波动速读

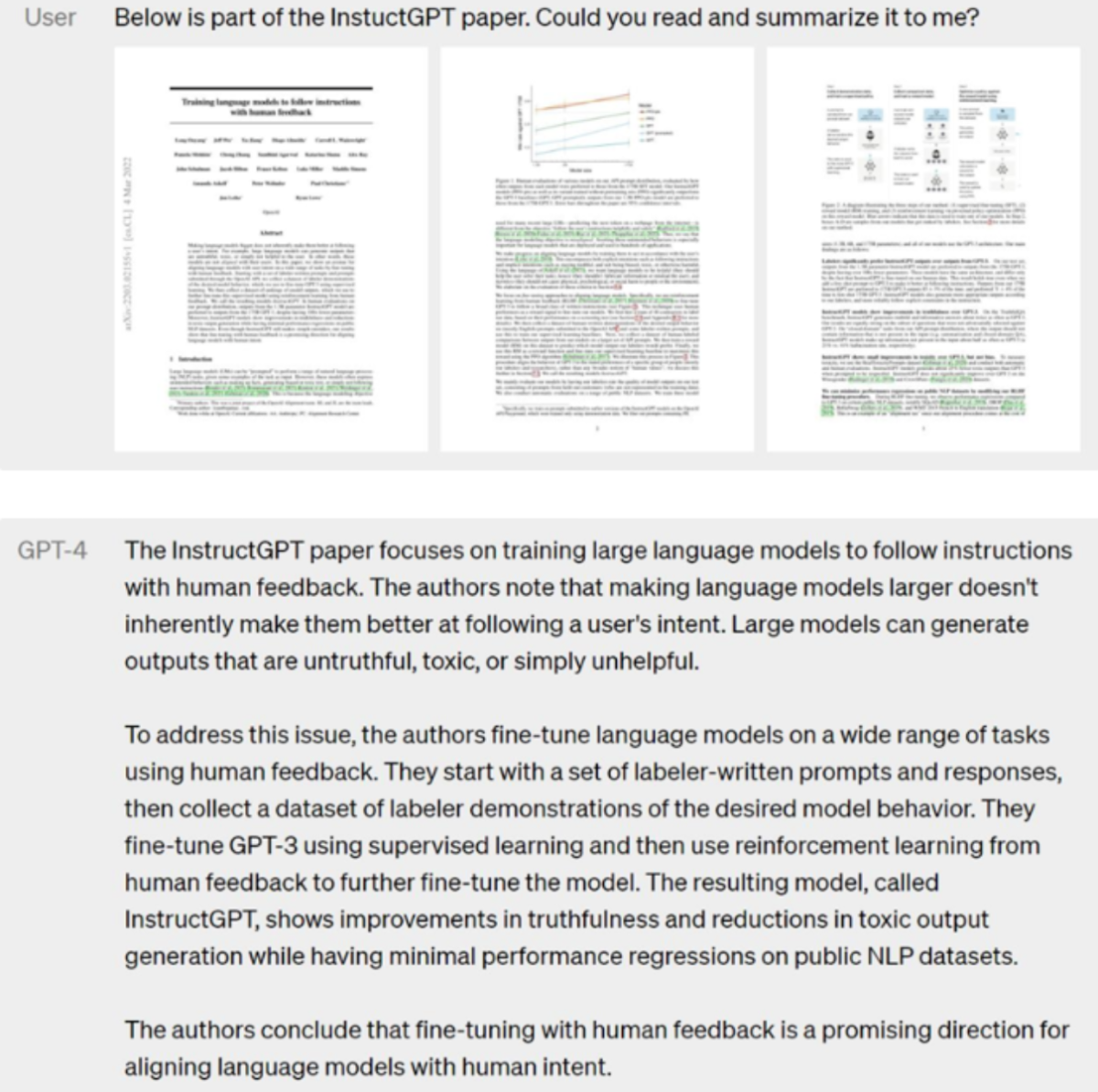

曾经爆火网络的“量子波动速读”竟然也在GPT-4上获得了重现。这种被机构滥用的反人类教育噱头,在GPT-4上却得到了完美的诠释。

有网友将一整篇论文上传给GPT-4,然后,GPT-4就在极短时间内完成了阅读,并给出清晰的总结摘要。

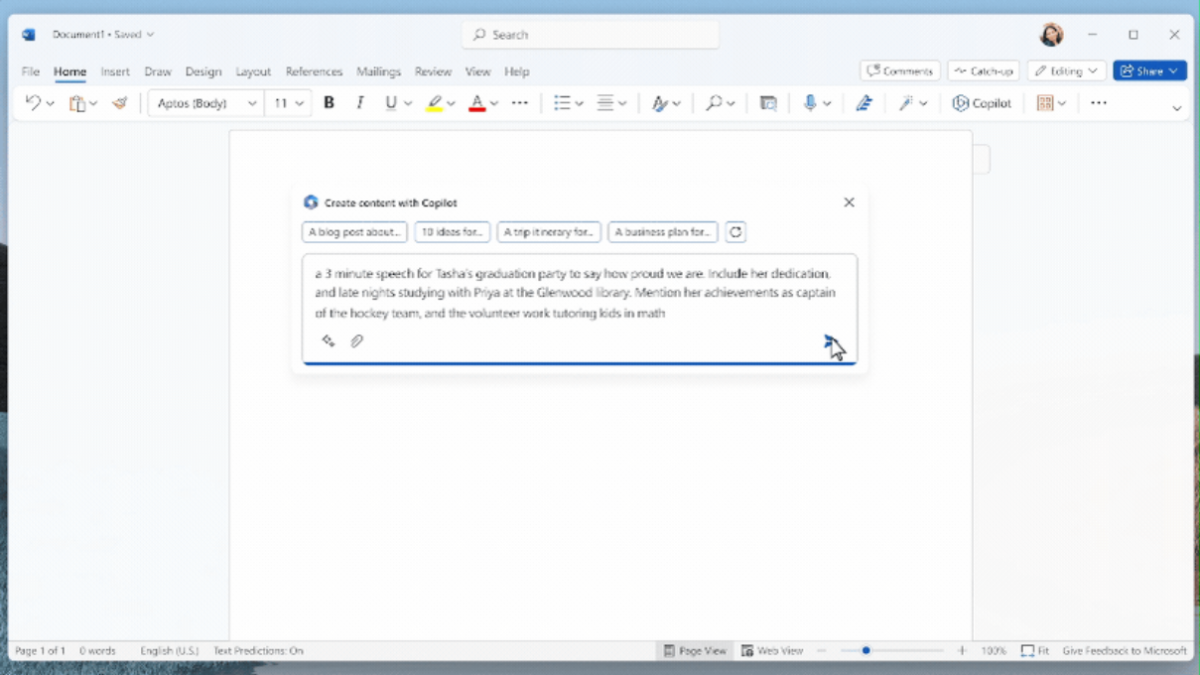

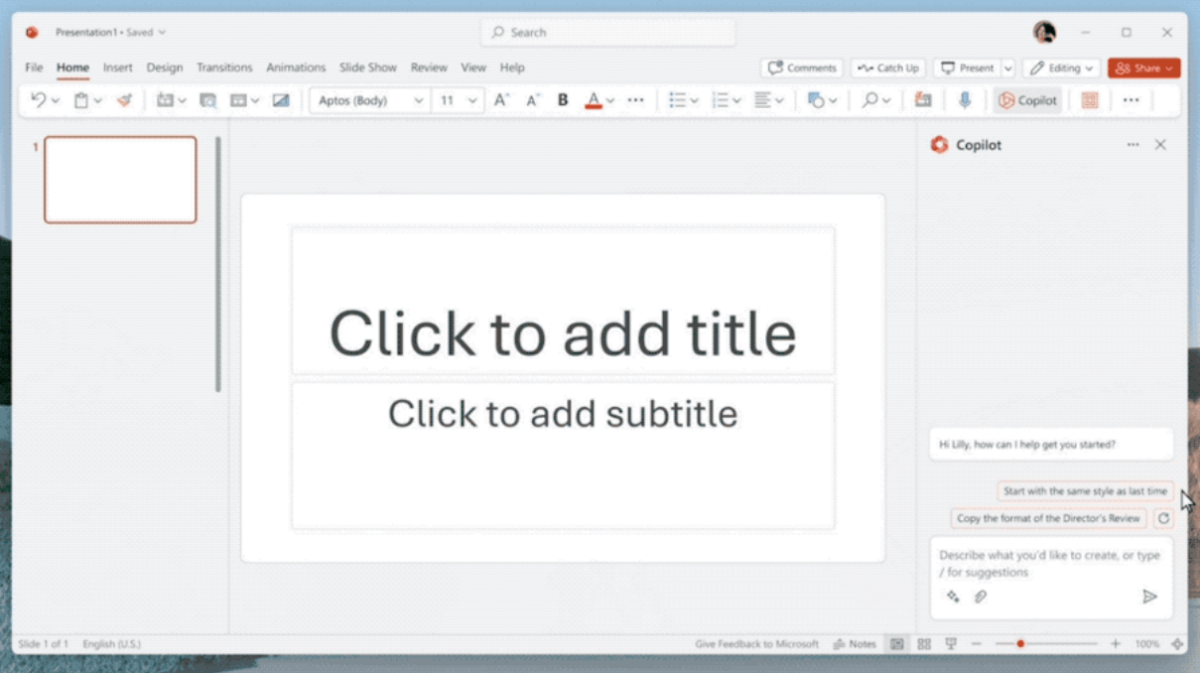

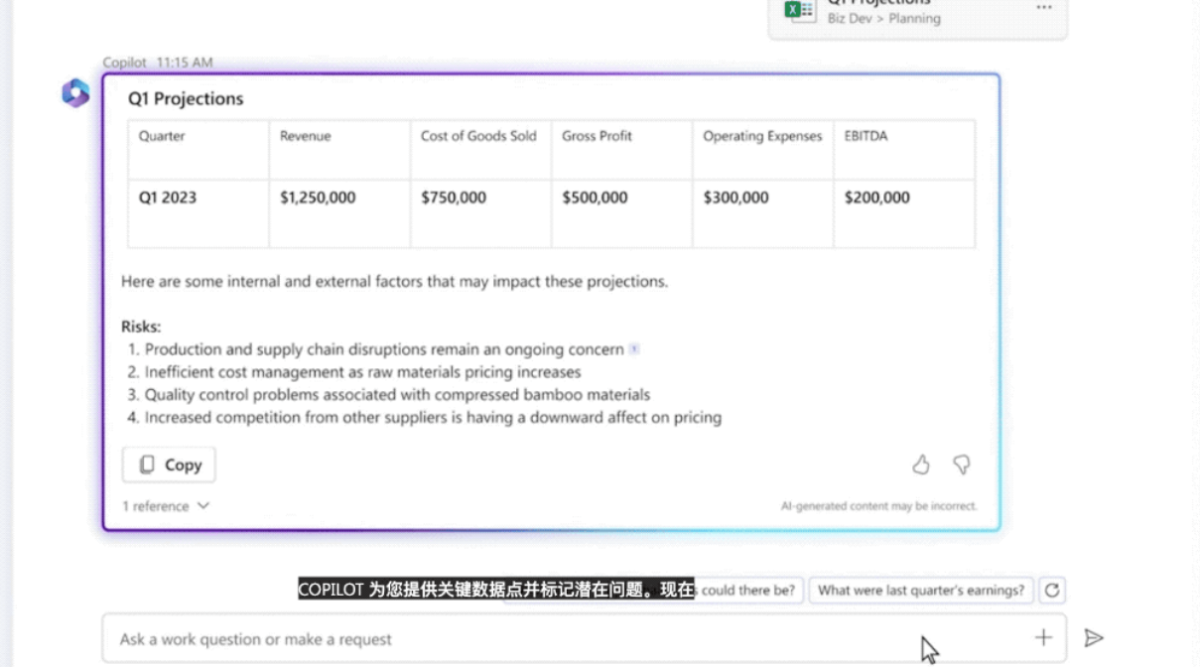

更可怕的是 2023年3月17日微软把AI神器GPT-4全面接入Office,名字叫Microsoft 365 Copilot(副驾驶),这下ChatPPT、ChatWord、ChatExcel一家整整齐齐,打工人的工作方式被彻底改变。

在Word里,你可以让Copilot给你写文章、改文字、做总结,甚至还可以帮你正确把握文章中的语气,给出各种建议,语气是专业的、热情的,还是随意的,任你挑选。另外,Copilot还可以改进写作,建议加强论证的方法,或者消除不一致的地方。

而且能根据Word文档的内容一键做出精美排版

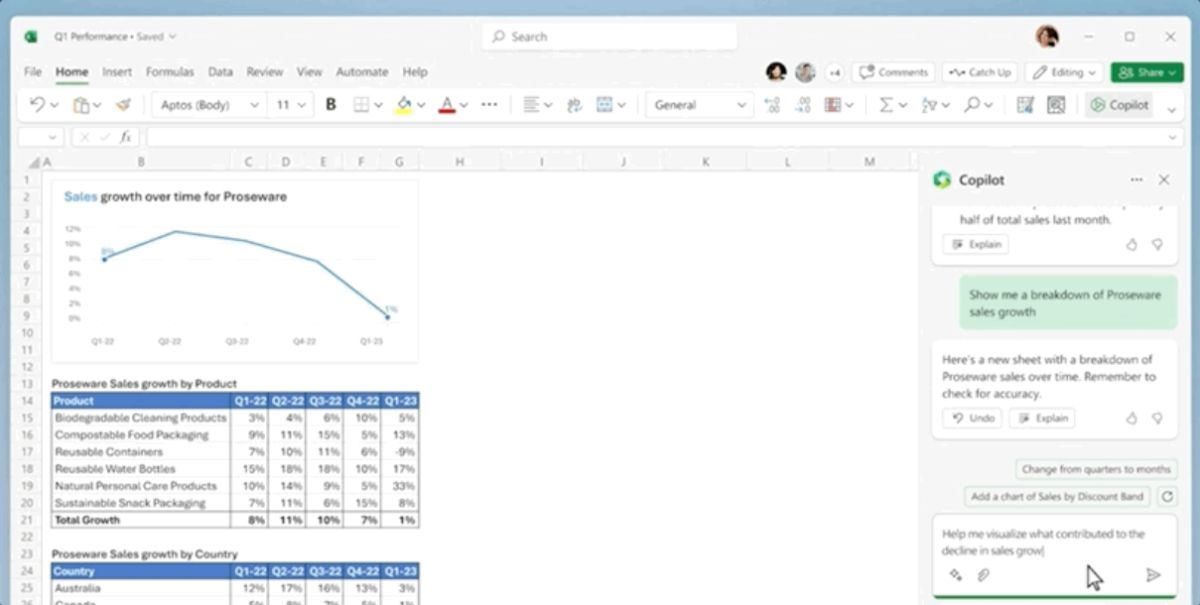

在Excel中,Copilot几秒内就帮你生成清晰的表格,并且搞定任何数据处理。而且,它会根据这些数据即时地创建出基于SWOT的分析,或者各种数据透视表。

还可以从Excel数据中直接生成战略分析,直接当成新的一页让AI添加到PPT里。

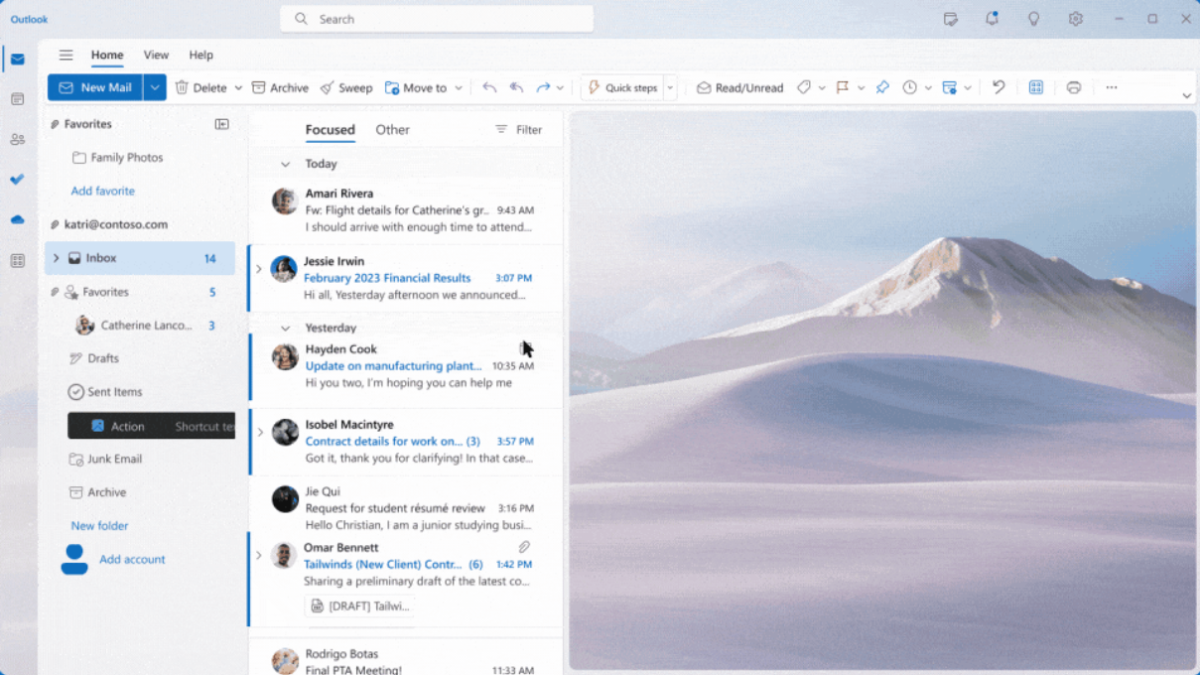

在Outlook中,Copilot可以帮你写邮件,你起个头,打个底,它就自动给你补完整,顺便大大润色你的文字。此外,它还会自动帮你汇总邮箱信息。甚至,根据你可以指定它写什么语气的邮件,写多少个字。

在Teams中,Copilot能帮你实时总结项目,同时执行任务,让整个会议效率大大提升;在开会时,它会帮你自动转录;如果你忘了啥事,它还会自动提醒你。

......如此种种,真是一键淘汰打工人

附:

论文:[2303.08774] GPT-4 Technical Report

GPT-5:AGI未来可期

GPT-4发布后,全球对于OpenAI的关注度持续提升。一个国外博主 AI Explained从OpenAI发布的一篇技术论文中,找出了其中的隐藏线索。

● GPT-5或完成训练

其中谈及到OpenAI在GPT-4之前花费8个月时间进行安全研究、风险评估和迭代。也就是说,OpenAI在去年年底推出ChatGPT的时候,已经有了GPT-4。博主便预测GPT-5的训练时间不会很久,甚至他认为GPT-5已经可能训练完成。但接下来的问题是漫长的安全研究和风险评估,可能是几个月,也可能是一年甚至更久。

● OpenAI两年内接近AGI,会协助超越它的公司

OpenAI在论文中还有一个非常大胆的承诺:如果另一家公司在我们之前实现了接近AGI(Artificial general intelligence ,通用人工智能 ,普遍比人类更聪明,并且有益于全人类的人工智能系统。),那我们承诺不会跟它做竞争,相反,会协助完成那个项目。但这种情况发生的条件,可能是另一家公司需得在未来两年内,成功接近AGI的机会在一半或以上。

当然也有更官方的消息OpenAI总裁格雷格·布罗克曼称,公司正在测试GPT-4高级版本,是普通GPT-4储存内容能力的5倍

关于 GPT-5 的性能和优势,目前还没有确切的信息,因为 GPT-5 尚未发布或公开发表。但是,基于过去的模式和趋势,我们可以大致预测 GPT-5 的可能方向和改进之处:

首先,GPT-5 可能会在语言理解和生成方面更加准确和流畅,包括更好的上下文理解能力、更多的知识表示和推理能力、更好的对话和问答能力等。它也可能会更加注重个性化,根据用户的个人偏好和习惯提供更加个性化的响应和服务。

其次,GPT-5 可能会加强对多模态数据的理解和生成能力,包括图像、视频、音频等。这将有助于更好地支持多媒体数据的分析和处理,使 GPT-5 能够更好地应用于虚拟助手、智能家居、虚拟现实等多领域应用。

另外,GPT-5 也可能会更注重可解释性和透明度,使其生成的结果更加可靠、可解释,更易于被人类理解和接受。同时,GPT-5 还可能会更加高效和节能,更适合于嵌入式系统和移动设备等资源受限的环境中使用。

总之,GPT-5 可能在多个方面都有所改进和突破,使得它能够更好地满足人们不断增长的语言和认知需求,提供更加智能化和个性化的服务和支持。或许我们期待的AGI就在不远的将来等着我们!

最后

文章最后我们使用ChatGPT给我生成一下文章结尾吧:

GPT的前世今生和未来,代表着自然语言处理技术的不断进步和发展。从GPT-1到GPT-4,再到未来的GPT-5,每一代的变革都为我们提供了更加高效、准确和智能的语言交互方式,并为各行各业的应用带来更多的新的机遇和挑战。

未来的GPT-5将是什么样子呢?随着技术的不断发展,GPT-5将能够更好地理解人类语言,并创造出更为真实、丰富和有趣的语言内容。我们可以期待更加精准的语言模型、更加高效的计算方法、更加丰富的语言生成能力和更加智能化的交互方式。

在未来,GPT-5将成为自然语言处理技术的新里程碑,为构建智慧社会做出巨大的贡献。

让我们期待GPT技术的更加精进和发展,为未来的人工智能之路注入新的活力和动力。期待未来的GPT带来的更多惊喜和突破,为我们的生活和工作带来更多便利和智能。

我们相信,未来的GPT将成为人类智慧的重要组成部分,为构建智慧社会做出巨大的贡献。

闪电发卡ChatGPT产品推荐:

ChatGPT独享账号:https://www.chatgptzh.com/post/86.html

ChatGPT Plus共享账号:https://www.chatgptzh.com/post/319.html

ChatGPT Plus独享账号(购买充值代充订阅):https://www.chatgptzh.com/post/306.html

ChatGPT APIKey购买充值(直连+转发):https://www.chatgptzh.com/post/305.html

ChatGPT Plus国内镜像逆向版:https://www.chatgptzh.com/post/312.html

ChatGPT国内版(AIChat):https://www.chatgptzh.com/post/318.html