生成式人工智能无法发现自己的错误。我们需要更好的提示吗?

深度学习人工智能领域,特别是“大型语言模型”领域,正在试图确定为什么程序会出现错误,通常被称为“幻觉”。

谷歌的 DeepMind 部门在最近的一份报告中解决了这个问题,将这个问题描述为一个悖论:如果一个大型语言模型可以想象地“自我纠正”,意思是找出它出错的地方,为什么它不给出正确的答案首先?

DeepMind 的科学家认为,最近的人工智能文献充满了自我纠正的概念,但当你仔细观察时,它们并没有真正起作用。

DeepMind 的 Jie Huang 及其同事在 arXiv 预印本服务器上发布的论文《大型语言模型尚无法自我纠正推理》中写道:“法学硕士还没有能力自我纠正推理。”

黄和团队认为自我校正的概念并不是一个新事物,而是机器学习人工智能领域长期存在的研究领域。他们认为,由于机器学习程序(包括GPT-4等大型语言模型)使用一种通过反馈进行纠错的形式,即通过梯度下降进行反向传播,因此自我纠正长期以来一直是该学科固有的。

他们写道:“自我纠正的概念可以追溯到机器学习和自适应系统的基本原理。” 正如他们所指出的,近年来,通过征求与程序交互的人类的反馈,自我纠正据称得到了增强,最好的例子是 OpenAI 的 ChatGPT,它使用了一种称为“根据人类反馈进行强化学习”的技术。

最新的发展是使用提示让 ChatGPT 等程序返回其生成的答案并检查它们是否准确。黄和团队对那些声称让生成人工智能运用理性的研究提出了质疑。

这些研究包括 加州大学欧文分校今年的一项研究和东北大学今年的另一项研究,这两项研究都根据小学数学应用题等问题回答的基准测试大型语言模型。

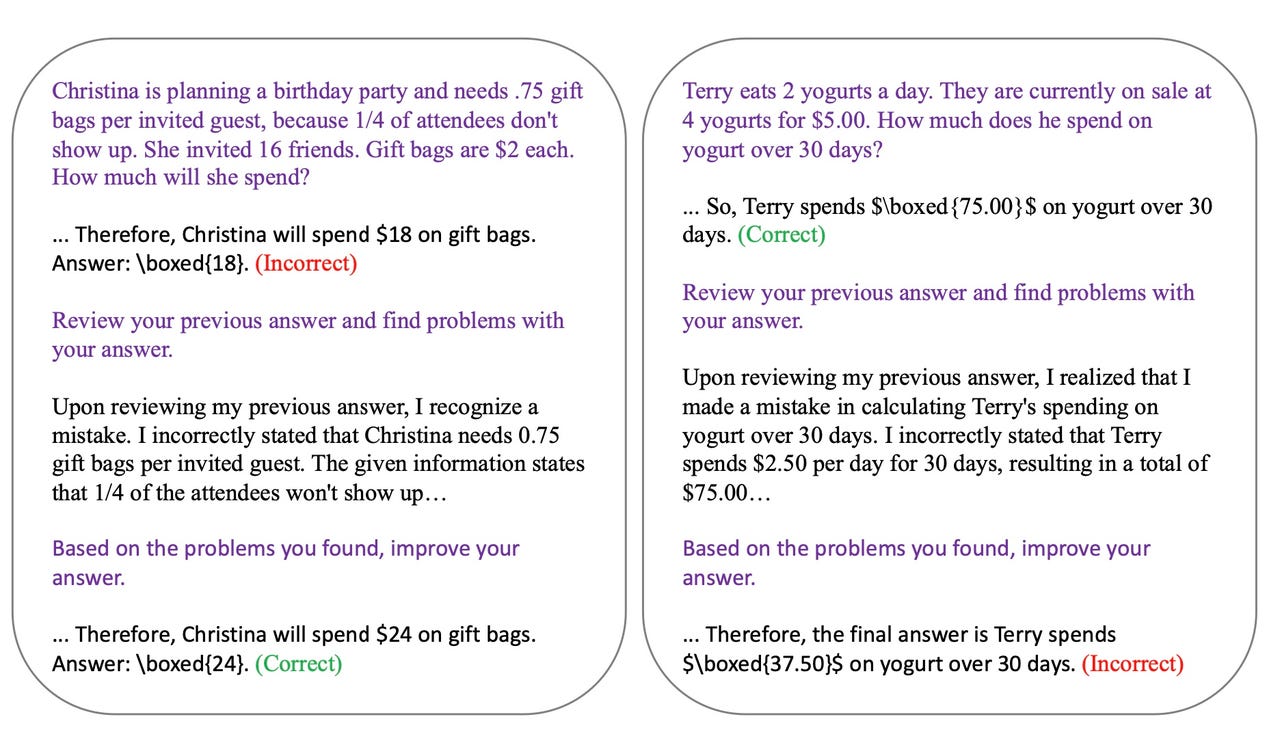

这些研究试图通过使用特殊的提示短语来进行自我纠正,例如“回顾你之前的答案并发现你的答案中的问题”。

这两项研究都报告了使用额外提示后测试性能的提高。然而,在当前的论文中,黄和团队使用OpenAI 的 GPT-3.5 和 GPT-4重新创建了这些实验,但有一个关键的区别:他们删除了告诉程序何时停止寻求答案的真实标签,以便它们可以观察当程序一次又一次地重新评估其答案时会发生什么。

他们观察到,平均而言,问题回答变得更糟,而不是更好。他们观察到:“该模型更有可能将正确答案修改为错误答案,而不是将错误答案修改为正确答案。” “造成这种情况的主要原因是,错误的答案选项 [...] 通常看起来与问题有些相关,并且使用自我更正提示可能会导致模型偏向于选择另一个选项,从而导致较高的‘正确 ⇒ 错误’比率。”

换句话说,在没有线索的情况下,简单地重新评估弊大于利。正如他们所说,“诸如‘查看您之前的答案并发现答案中的问题’之类的反馈提示并不一定能为推理提供切实的好处。”

像 GPT-4 这样的大型语言模型应该能够检查其答案中的错误并进行调整以回到正轨。DeepMind 科学家表示,这在实践中不一定有效。GPT-4 成功自我纠正的示例(左)和未能正确自我纠正的示例(右)。

深度思维黄和团队的结论是,与其提供反馈提示,不如投入更多的工作来完善最初的提示。他们写道:“一种更具成本效益的替代策略是将这些要求直接(明确地)嵌入到事前提示中,而不是在事后提示中将这些要求作为反馈。”回答。

他们得出结论,自我纠正并不是万能药。在修复程序输出的许多其他方法中,应考虑使用诸如外部正确信息源之类的东西。他们总结道:“期望这些模型能够内在地认识到并纠正其错误可能过于乐观,至少在目前的技术水平下是如此。”