ChatGPT API中的Tokens限制及其解决方案

闪电发卡ChatGPT产品推荐:

ChatGPT独享账号:https://www.chatgptzh.com/post/86.html

ChatGPT Plus独享共享账号购买代充:https://www.chatgptzh.com/post/329.html

ChatGPT APIKey购买充值(直连+转发):https://www.chatgptzh.com/post/348.html

ChatGPT Plus国内镜像(逆向版):https://www.chatgptgm.com/buy/23

ChatGPT国内版(AIChat):https://aichat.shandianfk.com

客服微信:1、chatgptpf 2、chatgptgm 3、businesstalent

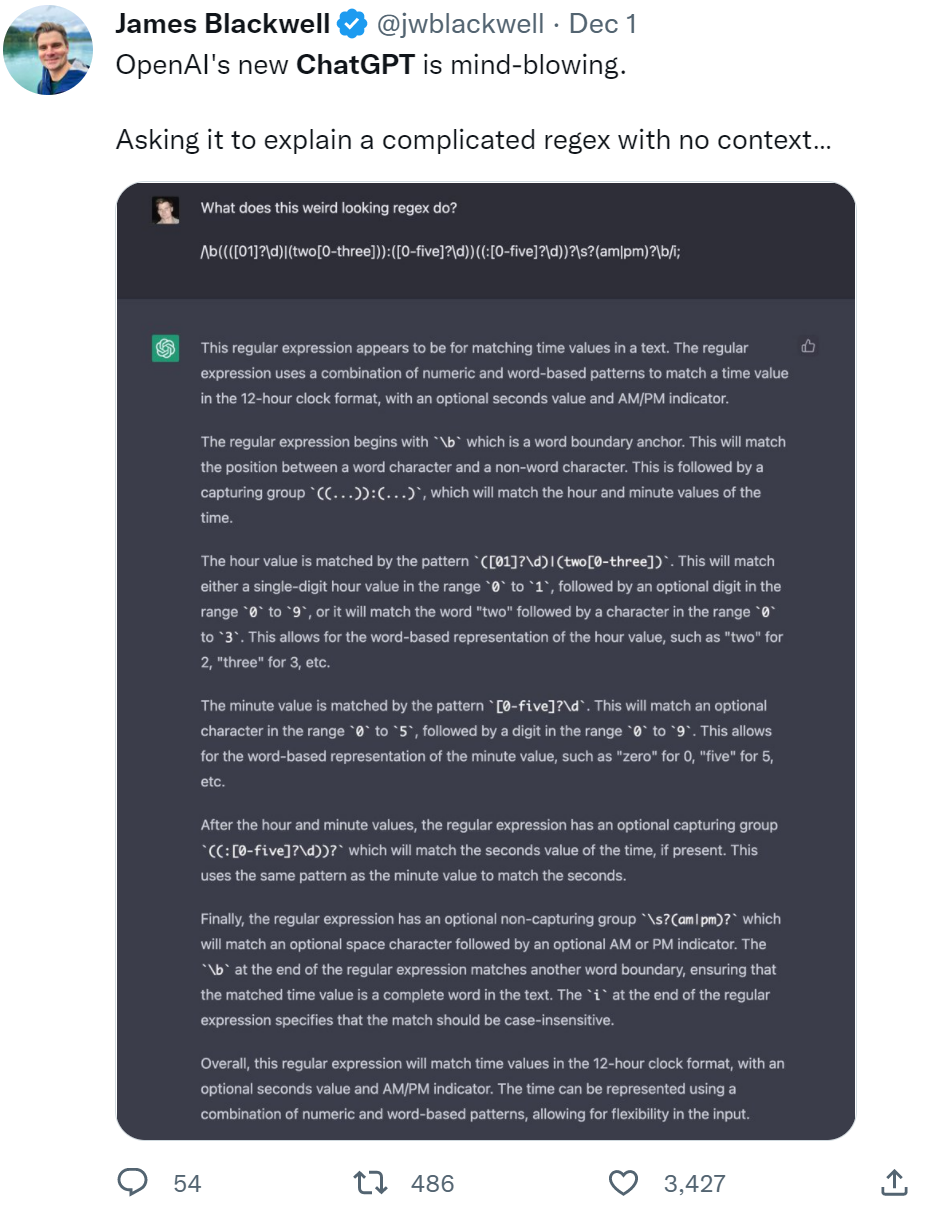

随着人工智能技术的发展,尤其是在自然语言处理领域,ChatGPT作为OpenAI推出的强大语言模型,受到了广泛关注和应用。然而,在使用ChatGPT API的过程中,开发者们往往会遇到一个关键问题:Tokens限制。本文将详细探讨ChatGPT API中的Tokens限制问题,并提出相应的解决方案。

什么是Tokens?

在讨论Tokens限制之前,首先需要理解什么是Tokens。在自然语言处理中,Tokens是指文本中的基本单位,可以是一个词、一部分词或一个字符。在ChatGPT中,Tokens用于计算输入和输出的字数,以便模型能够更有效地处理和生成文本。

每个Tokens可以是一个单词、一部分单词或一个字符。例如,单词“ChatGPT”可能被分解为“Chat”和“GPT”两个Tokens,而一个句子“Hello, world!”则可能被分解为若干个Tokens。

ChatGPT API中的Tokens限制

ChatGPT API对每次请求的Tokens数量设置了限制。这是为了确保模型在合理的资源范围内运行,同时也是为了避免系统过载和延迟过大。目前,API对每次请求的最大Tokens数量通常限制在4096个。这个数量包括输入文本和模型生成的输出文本的总和。

Tokens限制的影响

Tokens限制对开发者和用户有着直接的影响。具体体现在以下几个方面:

长文本处理:对于需要处理长文本的应用来说,Tokens限制可能会导致文本被截断,从而影响上下文的完整性和理解。

对话长度:在对话应用中,连续的对话会增加Tokens的数量,导致较长的对话无法一次性处理,需要进行拆分。

生成内容的限制:由于输出文本也包含在Tokens限制内,生成较长文本的需求可能无法一次性满足,需要分段生成。

解决Tokens限制的策略

面对Tokens限制,开发者可以采取多种策略来优化使用体验和效果。以下是一些常见且有效的解决方案:

1. 文本预处理与压缩

通过对输入文本进行预处理和压缩,可以有效减少Tokens数量。例如:

删除冗余信息:去除不必要的空格、标点符号和重复信息。

简化语言:将复杂的句子结构简化,使用简洁明了的表达方式。

文本摘要:对长文本进行摘要处理,只保留关键内容。

2. 分段处理

对于需要处理的长文本,可以将其分段处理。具体方法如下:

分段输入:将长文本按段落或句子分割成多个部分,逐段输入模型进行处理,然后再将结果组合起来。

滑动窗口:使用滑动窗口技术,在每次处理时保留部分上下文信息,确保连续性和连贯性。

3. 控制生成长度

在生成文本时,可以通过设置最大Tokens数量来控制生成长度,确保不会超出限制。例如:

设置max_tokens参数:在请求中明确指定生成文本的最大Tokens数量,以避免超过总Tokens限制。

分步生成:对于需要生成较长文本的场景,可以分多次生成,每次生成一部分内容。

4. 使用更高级的模型或API

如果当前Tokens限制对应用的需求仍然不足,可以考虑以下方式:

升级模型:OpenAI可能会提供更高级版本的模型,这些模型可能具有更高的Tokens限制,可以更好地满足需求。

联系OpenAI定制:对于一些特定的企业和应用需求,可以联系OpenAI进行定制化服务,以获取更高的Tokens限制。

5. 结合其他技术

在一些复杂应用场景中,可以结合其他技术手段来优化处理效果:

文本压缩算法:使用高级的文本压缩算法(如BERT压缩)来减少输入文本的长度。

外部存储与检索:将部分不常用的文本信息存储在外部数据库中,需要时再检索和加载,避免一次性输入过多内容。

案例分析:ChatGPT API在实际应用中的优化

案例1:在线客服系统

某公司开发了一款基于ChatGPT的在线客服系统,初期版本中由于用户对话较长,频繁遇到Tokens限制的问题。为解决这一问题,团队采用了以下优化措施:

文本预处理:在用户输入之前,对文本进行预处理,删除冗余信息,压缩文本长度。

分段处理:将用户的长对话分段处理,确保每次请求的Tokens数量不超过限制。

控制生成长度:设置max_tokens参数,控制每次生成的回答长度,同时分步生成较长的回答。

通过这些优化措施,系统的响应速度和准确性得到了显著提升。

案例2:内容生成平台

一家内容生成平台使用ChatGPT来自动撰写文章和生成营销文案。由于生成内容较长,初期版本常遇到Tokens超限的问题。为解决这一问题,团队采取了以下策略:

文本摘要与分段生成:对于需要生成的长文章,先生成各段落的摘要,然后分段进行详细生成,最后将各段内容组合成完整文章。

滑动窗口技术:在生成长篇文案时,使用滑动窗口技术保持上下文连续性,确保生成内容的连贯性。

这些措施有效解决了Tokens限制问题,使平台能够生成更长、更连贯的内容。

结论

ChatGPT API中的Tokens限制是开发者在使用过程中需要面对的一个重要问题,但通过合理的策略和优化方法,可以有效克服这一限制,提升应用的效果和用户体验。文本预处理、分段处理、控制生成长度以及结合其他技术手段都是常见且有效的解决方案。在实际应用中,开发者应根据具体需求和场景选择适合的方法,持续优化和改进系统性能。

通过本文的探讨,希望能为广大开发者提供一些有价值的参考和启示,帮助大家更好地利用ChatGPT API,构建更加智能和高效的应用。