案例分析:Google Translate - Transformer教程

大家好,今天我们来聊聊Google Translate背后的技术——Transformer模型。Google Translate自从2006年问世以来,已经经历了多次重大技术变革,而Transformer模型的引入无疑是其中最关键的一步。本文将通过一个案例分析,详细介绍Transformer模型的工作原理和在Google Translate中的应用。

什么是Transformer模型?

在深入了解Google Translate之前,我们先来看看Transformer模型到底是什么。Transformer模型是由Vaswani等人在2017年提出的一种神经网络架构,它特别擅长处理自然语言处理(NLP)任务。与传统的RNN(循环神经网络)不同,Transformer模型不依赖于序列信息,而是使用一种称为“自注意力机制”(self-attention)的技术来处理输入数据。

Transformer的核心:自注意力机制

自注意力机制是Transformer模型的核心部分,它能够在处理每个词时,关注输入序列中的所有其他词。自注意力机制通过计算“查询”(query)、“键”(key)和“值”(value)来完成这一任务。具体来说,每个词在输入序列中都会生成一个查询向量、一个键向量和一个值向量,然后通过点积操作和归一化处理,生成注意力分数。这些分数用于加权输入序列中的词,从而使模型能够更好地理解上下文关系。

Google Translate中的Transformer应用

自从2016年开始,Google Translate逐渐从基于统计的方法转向神经网络方法。2017年,Google宣布将其翻译系统全面升级为基于Transformer的模型。这一改变带来了翻译质量的显著提升。

如何处理多语言翻译?

Google Translate需要处理上百种语言的翻译,这对模型的泛化能力提出了极高的要求。Transformer模型的优势在于其模块化和可扩展性,使得它能够高效地处理多语言翻译任务。通过引入多头自注意力机制,模型可以在不同的语言之间共享参数,从而提高翻译效果。

训练和推理

训练一个高质量的Transformer模型需要大量的双语语料库。Google使用了来自互联网的海量数据,通过预训练和微调的方式,让模型学会不同语言之间的对应关系。在实际应用中,Google Translate还结合了机器学习的其他技术,例如序列到序列(seq2seq)模型和注意力机制,以进一步提升翻译质量和速度。

Transformer模型的优势

相比传统的RNN和LSTM模型,Transformer模型有以下几个显著的优势:

- 并行计算:Transformer不依赖于序列信息,可以并行处理整个输入序列,提高了计算效率。

- 更长的依赖关系:通过自注意力机制,Transformer可以更好地捕捉输入序列中的长距离依赖关系。

- 更好的泛化能力:Transformer模型在处理多语言翻译时表现出更强的泛化能力,能够有效地共享跨语言的信息。

实际应用中的挑战

虽然Transformer模型在很多方面都有显著优势,但在实际应用中仍然面临一些挑战。例如,训练一个高质量的Transformer模型需要大量的计算资源和数据,这对一些资源有限的机构来说是一个不小的挑战。此外,如何处理低资源语言的翻译也是一个亟待解决的问题。

未来展望

随着技术的不断进步,Transformer模型有望在更多的领域得到应用。例如,在自然语言生成、文本摘要和对话系统等方面,Transformer模型已经展现出了巨大的潜力。对于Google Translate来说,未来的重点将是进一步提升翻译质量,尤其是对于长文本和复杂句子的处理。

总结

总的来说,Transformer模型的引入使得Google Translate在翻译质量和效率上有了质的飞跃。通过自注意力机制和多头注意力机制,Transformer能够更好地理解和生成自然语言。这不仅提升了用户的翻译体验,也为自然语言处理技术的发展指明了方向。

希望通过本文的介绍,大家对Transformer模型和Google Translate有了更深入的了解。如果你对这个话题感兴趣,不妨进一步阅读相关的学术论文和技术文档,相信你会有更多的收获。

感谢大家的阅读,我们下期再见!

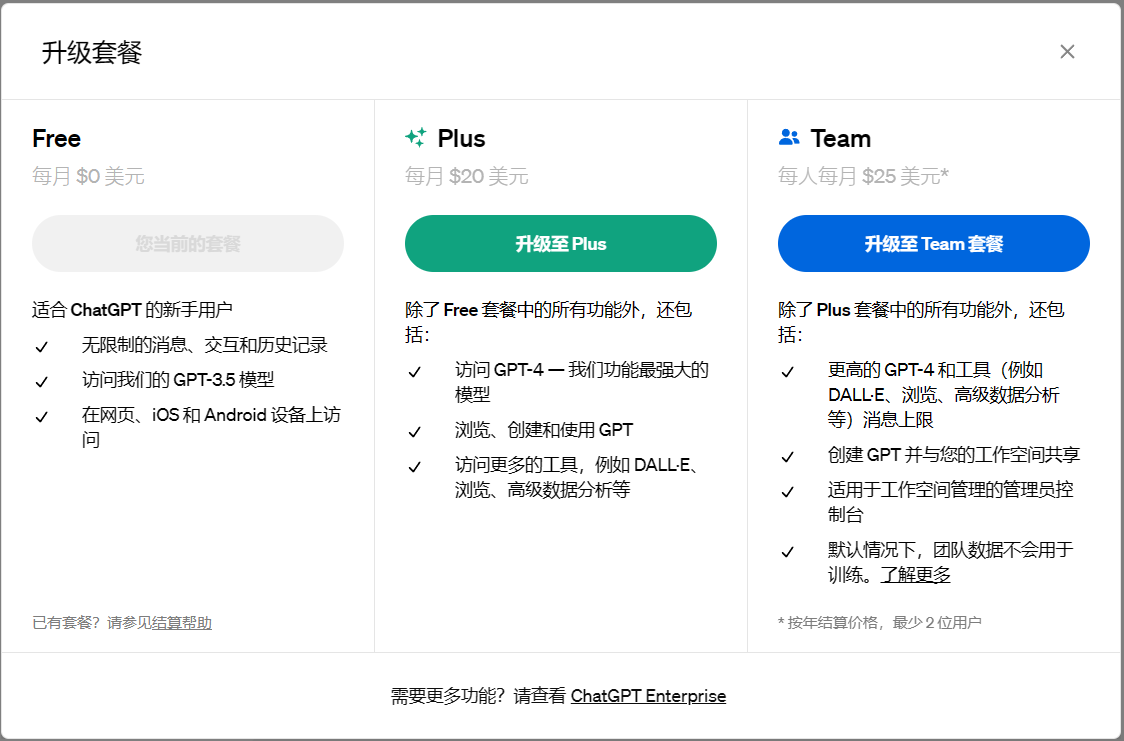

闪电发卡ChatGPT产品推荐:ChatGPT独享账号

ChatGPT Plus 4.0独享共享账号购买代充

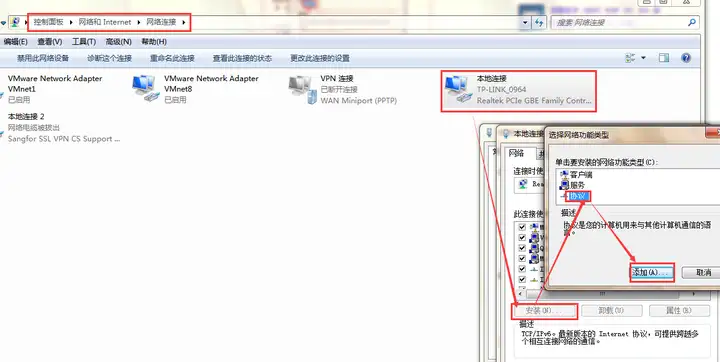

ChatGPT APIKey 3.5和4.0购买充值(直连+转发)

ChatGPT Plus国内镜像(逆向版)

ChatGPT国内版(AIChat)

客服微信:1、chatgptpf 2、chatgptgm 3、businesstalent